Escenarios de aprendizaje para evaluaciones cortas

|

Isaac Alpizar-Chacon Escuela de Administración de Tecnologías de Información Instituto Tecnológico de Costa Rica, Costa Rica |

Fecha de recepción: 29 de mayo del 2025 | Fecha de aprobación: 2 de setiembre de 2025

Resumen

Este artículo presenta una experiencia de evaluación en el curso “Desarrollo ágil de aplicaciones web” de la carrera de Administración de Tecnología de Información (ATI) del Instituto Tecnológico de Costa Rica, en la que se utilizó una herramienta educativa para implementar evaluaciones cortas en el aula y en la casa. El objetivo fue analizar cómo diferentes secuencias de actividades (escenarios) impactan el aprendizaje, la motivación y la participación del estudiantado. A través de una combinación de recolección de datos cuantitativos y cualitativos, se identificaron preferencias estudiantiles y posibles implicaciones pedagógicas para cursos en entornos mixtos.

Palabras claves: aprendizaje mixto, herramientas de votación, investigación educativa

Abstract

This article presents an assessment experience in the course “Agile Web Development” of the Information Technology Management program at the Costa Rica Institute of Technology. An educational tool was used to implement short assessments both in-class and at-home. The aim was to analyze how different sequences of activities (scenarios) influence students’ learning, motivation, and participation. By combining quantitative and qualitative data collection, we identified student preferences and potential pedagogical implications for courses in blended learning environments.

Keywords: blended learning, voting tools, educational research

Introducción

Los entornos de aprendizaje mixtos —aquellos que combinan componentes presenciales con actividades en línea— [2] se han consolidado como una modalidad clave en la educación superior, especialmente a raíz de la pandemia por COVID-19 [6]. Esta transición acelerada a formatos híbridos ha llevado a repensar no solo la manera en que se imparten los contenidos, sino también cómo se diseñan las actividades que promueven el aprendizaje efectivo y sostenido.

Diseñar actividades didácticas en cursos con formato mixto presenta múltiples desafíos. Uno de ellos es cómo mantener el compromiso del estudiantado a lo largo de las sesiones sincrónicas y asincrónicas, y cómo promover el aprendizaje activo y autorregulado en ambos entornos [5]. Una estrategia ampliamente utilizada para este fin es la incorporación de evaluaciones cortas. En particular, las evaluaciones formativas permiten a los estudiantes reflexionar sobre su propio aprendizaje y recibir retroalimentación oportuna, sin la presión que implica una nota. En este contexto, herramientas de votación [3] como Kahoot! se han popularizado por su facilidad de uso y su capacidad de dinamizar las clases. Estas plataformas permiten al profesorado crear cuestionarios interactivos a los que el estudiantado responde en tiempo real desde sus dispositivos, generando retroalimentación inmediata y fomentando la participación. No obstante, estas herramientas suelen centrarse exclusivamente en el espacio del aula, limitando su aplicación más allá del entorno sincrónico.

En este trabajo, presentamos una experiencia de uso de Quizitor, una herramienta educativa diseñada para aplicar evaluaciones cortas tanto en el aula como en casa. A diferencia de las plataformas tradicionales de votación, Quizitor permite crear actividades que se adaptan a distintos momentos del proceso de enseñanza-aprendizaje, manteniendo un diseño sencillo pero funcional. El estudio se llevó a cabo en un curso universitario de desarrollo web y contempló distintos escenarios de aplicación: evaluaciones en el aula al inicio o al final de la clase, y evaluaciones individuales en casa. Se analizaron las implicaciones pedagógicas de cada uno de estos escenarios, así como las percepciones del estudiantado sobre su efectividad y utilidad.

Este trabajo se realizó en el contexto del proyecto de investigación “Medición de la eficacia de la (auto) evaluación realizada en el aula y en casa a través del uso de una herramienta educativa”, registrado ante la Vicerrectoría de Investigación y Extensión del TEC. El proyecto se ejecutó entre julio 2023 y diciembre 2024.

Herramientas

En los últimos años, las herramientas de votación digital se han consolidado como un recurso popular para fomentar la participación activa del estudiantado, especialmente en entornos de clase sincrónicos, presenciales o virtuales. Estas herramientas permiten al profesorado aplicar preguntas breves en tiempo real, recopilar respuestas de manera inmediata y adaptar la clase según las necesidades detectadas. Su uso frecuente se asocia a estrategias de evaluación formativa, ya que proporcionan retroalimentación instantánea y promueven la reflexión sobre el aprendizaje [3].

Un ejemplo de estás plataformas es Kahoot!1, la cual ha probado ser efectiva [8]. Otros ejemplos son Mentimeter2 y Socrative3. Estas herramientas se valoran por su facilidad de uso, dinamismo y atractivo visual, lo cual las hace especialmente útiles para generar ambientes de aprendizaje interactivos. Sin embargo, su uso suele limitarse al espacio del aula o a momentos puntuales dentro de una sesión.

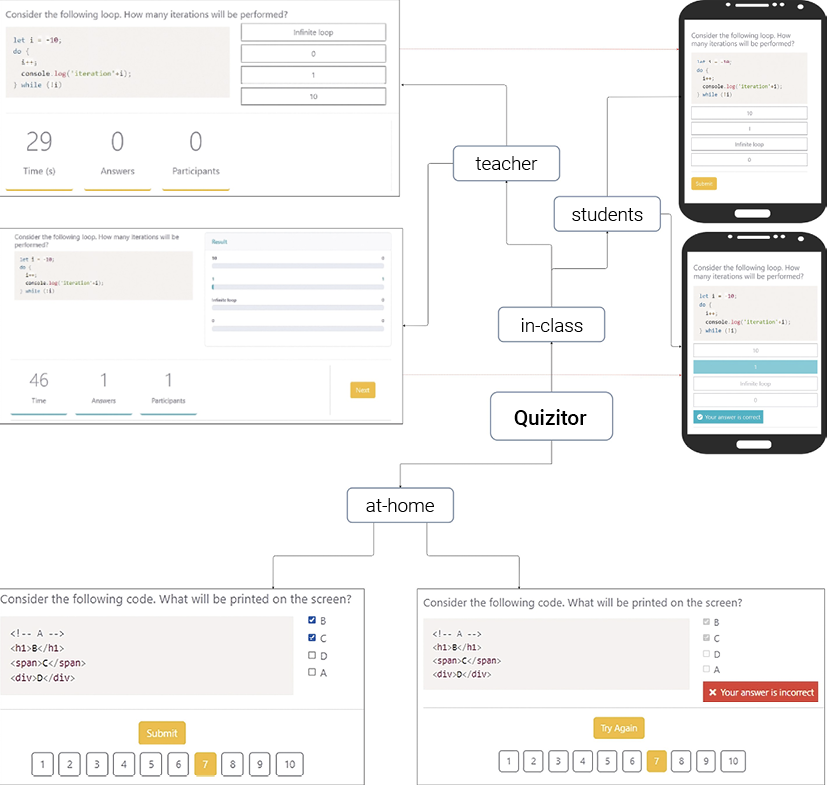

En el marco de este proyecto, se empleó una herramienta distinta: Quizitor, la cual ha sido desarrollada en la Universidad de Utrecht, Países Bajos [4]. A diferencia de las plataformas antes mencionadas, Quizitor fue diseñada para ser utilizada tanto en el aula como fuera de ella (evaluaciones en la casa), integrándose a actividades evaluativas con propósitos formativos y sumativos. La herramienta permite aplicar cuestionarios breves con preguntas de opción múltiple, selección múltiple y preguntas abiertas, y ofrece funcionalidades como pistas, retroalimentación inmediata y seguimiento del progreso por parte del profesorado. La Figura 1 muestra la herramienta Quizitor y sus diferentes modos de uso.

Su diseño minimalista y su enfoque en la simplicidad hacen de Quizitor una opción versátil, comparable en experiencia de uso con herramientas comerciales, pero con mayor flexibilidad para adaptarse a distintos momentos del proceso de enseñanza. En este estudio, se usó para implementar diferentes secuencias de evaluación, analizando cómo cada escenario impacta en la participación, motivación y aprendizaje del estudiantado.

Figura 1: Herramienta Quizitor y sus dos modos de uso: evaluaciones en el aula (in-class) y evaluaciones en la casa (at-home). Figura tomada de Sosnovsky and Hamzah [7].

Experiencia en el curso

Quizitor se utilizó en el curso “Desarrollo Ágil de Aplicaciones Web”, de la carrera de Administración de Tecnología de Información del TEC, durante el segundo semestre del 2023. El curso tuvo una duración de 16 semanas lectivas y se impartió en modalidad sincrónica en línea, con una sesión semanal en vivo. La herramienta se empleó con fines tanto sumativos como formativos. La integración de este tipo de actividades resultó especialmente útil, ya que el curso no incluyó exámenes tradicionales como medio de evaluación. Además, dado que el estudiantado tenía acceso libre al uso de inteligencia artificial generativa (GenAI), se consideró relevante implementar mecanismos que permitieran monitorear y acompañar el proceso de aprendizaje de manera continua. Detalles adicionales sobre el uso de la GenAI en el curso están disponibles en [1].

Para la parte sumativa, se aplicaron evaluaciones en casa, las cuales contribuyeron con un 5% de la nota final del curso. Las personas estudiantes solo debían completar las evaluaciones para obtener el porcentaje asignado, es decir, su desempeño no fue tomado en cuenta para la calificación. Para la parte formativa, se utilizaron evaluaciones en el aula, aplicadas en dos escenarios distintos. En la primera parte del curso, hasta la semana 9, las evaluaciones en el aula se realizaron al final de la clase (Escenario 1), mientras que a partir de la semana 10 se aplicaron al inicio de la clase (Escenario 2).

En total, se llevaron a cabo 5 evaluaciones en el Escenario 1, otras 5 en el Escenario 2 y se habilitaron 22 evaluaciones para ser realizadas en casa. En el curso participaron 14 estudiantes. Al comienzo del curso, se informó a los estudiantes sobre los procedimientos del estudio. También se les indicó que su participación era voluntaria y que podían retirarse del estudio (aunque no de la parte evaluativa) en cualquier momento sin consecuencias.

La recolección de datos incluyó tanto el análisis de la interacción del estudiantado con la plataforma Quizitor como actividades cualitativas. Este artículo se enfoca en los hallazgos derivados del análisis cualitativo. En particular, se realizó un grupo focal con cinco estudiantes y dos entrevistas individuales al finalizar el curso. Dado que todos los estudiantes experimentaron ambos escenarios de evaluación durante el mismo curso, el análisis se centró en explorar cuál de las configuraciones preferían para las evaluaciones en el aula y las razones detrás de sus preferencias.

Preferencias

Los resultados del estudio reflejan impresiones mayoritariamente positivas sobre la herramienta Quizitor. En general, el estudiantado valoró su funcionalidad, destacando que es una herramienta fácil de usar, útil, intuitiva y con un diseño minimalista. También resaltaron la posibilidad de revisar las evaluaciones realizadas en casa como un apoyo para seguir el contenido del curso semana a semana. Además, consideraron positiva la inclusión de pistas como información adicional, y reconocieron que las evaluaciones en el aula y en casa se complementaban adecuadamente. Varios estudiantes indicaron que las evaluaciones en el aula contribuían a que las clases fueran más dinámicas.

En cuanto a la comparación entre evaluaciones en el aula y en casa, se encontró que ambas estaban alineadas con el contenido del curso. Sin embargo, varios estudiantes mencionaron que había demasiadas evaluaciones en casa sobre los mismos temas, lo que provocaba redundancia. Estas evaluaciones fueron descritas como largas y tediosas por algunos, y aunque permitían más tiempo de respuesta y la consulta de materiales, no todos los estudiantes se beneficiaban de este formato. De hecho, algunos reportaron sentirse más enfocados con las evaluaciones en el aula, mientras que las realizadas en casa resultaban más propensas a generar distracción. En ciertos casos, el tiempo extendido para resolver las evaluaciones en casa reducía su efectividad percibida.

Respecto al escenario preferido para las evaluaciones en el aula, seis estudiantes indicaron preferir que se realizaran al inicio de la clase (Escenario 2), mientras que dos se inclinaron por el formato tradicional al final (Escenario 1). Quienes favorecieron el Escenario 2 argumentaron que comenzaban la clase con más energía y enfoque, lo cual les ayudaba a activar conocimientos previos, retomar el hilo de los contenidos y asegurar la retención del material de la semana anterior. En cambio, los estudiantes que preferían las evaluaciones al final valoraban la oportunidad de evaluar su comprensión del tema recién abordado y detectar áreas que requerían repaso. Algunos mencionaron sentirse cansados al final de la clase, lo que afectaba su desempeño en el Escenario 1.

También se evidenció el impacto de las evaluaciones en las prácticas de estudio. Por ejemplo, varios estudiantes indicaron que responder incorrectamente a dos preguntas seguidas les motivaba a repasar el contenido. Asimismo, se observó que muchos repasaban el material antes de las evaluaciones en el

aula, especialmente cuando estas se ubicaban al inicio de la clase. La motivación para estudiar después de las evaluaciones, ya fueran en el aula o en casa, variaba en función del rendimiento individual y la carga académica. Algunos estudiantes señalaron sentirse particularmente impulsados a revisar ciertos temas luego de obtener respuestas incorrectas en las evaluaciones realizadas en casa.

Por último, algunos aspectos adicionales merecen ser destacados. El estudiantado valoró positivamente el anonimato ofrecido durante las evaluaciones en el aula, lo cual favoreció una participación más relajada. Asimismo, apreciaron que las evaluaciones realizadas en casa no fueran calificadas en función del desempeño, sino simplemente por haberlas completado. Esta característica redujo la presión asociada a la evaluación y también disminuyó el incentivo a copiar respuestas o a utilizar herramientas como ChatGPT de forma indebida.

La Figura 2 muestra un resumen de los principales hallazgos del estudio relacionados con los dos escenarios de aplicación de evaluaciones cortas en el aula.

Figura 2: Resumen de los dos escenarios para realizar evaluaciones cortas en el aula. Fuente: elaboración propia.

Conclusión

Esta experiencia sugiere que las evaluaciones cortas, bien diseñadas y aplicadas estratégicamente en un entorno mixto, pueden tener un impacto positivo en el compromiso y el aprendizaje autorregulado. La combinación de evaluaciones en el aula y en casa permite al estudiantado reflexionar sobre su progreso, y escenarios como evaluaciones cortas al inicio ofrecen ventajas pedagógicas que merecen ser exploradas en otros contextos educativos.

Se recomienda continuar investigando con muestras más amplias y en distintas asignaturas para fortalecer la validez de los hallazgos y adaptar herramientas como Quizitor a nuevas realidades educativas.

Referencias

[1] I. Alpizar-Chacon and H. Keuning. Student’s use of generative ai as a support tool in an advanced web development course. Proceedings of the 30th ACM Conference on Innovation and Technology in Computer Science Education V. 1, 2025.

[2] B. Anthony, A. Kamaludin, A. Romli, A. F. M. Raffei, D. N. A. E. Phon, A. Abdullah, and G. L. Ming. Blended learning adoption and implementation in higher education: A theoretical and systematic review. Technology, Knowledge and Learning, pages 1–48, 2022.

[3] S. W. Draper and M. I. Brown. Increasing interactivity in lectures using an electronic voting system. Journal of computer assisted learning, 20(2):81–94, 2004.

[4] A. Hamzah and S. Sosnovsky. Providing students with mobile access to an assessment platform: Lessons learned. International Journal of Mobile and Blended Learning (IJMBL), 15(2):1–16, 2023.

[5] S. Ko¸c, X. Liu, and P. Wachira. Assessment in online and blended learning environments. IAP, 2015.

[6] D. Mali and H. Lim. How do students perceive face-to-face/blended learning as a result of the covid-19 pandemic? The International Journal of Management Education, 19(3):100552, 2021.

[7] S. Sosnovsky and A. Hamzah. Improving prediction of student performance in a blended course. In International Conference on Artificial Intelligence in Education, pages 594–599. Springer, 2022.

[8] Q. Zhang and Z. Yu. A literature review on the influence of kahoot! on learning outcomes, interaction, and collaboration. Education and Information Technologies, 26(4):4507–4535, 2021.

Sobre el autor

Isaac Alpízar-Chacón

Profesor asociado a tiempo parcial en la Escuela de Administración de Tecnologías de Información del TEC y, además, profesor asistente en la Universidad de Utrecht, Países Bajos. Posee un doctorado en Ciencias de la Información y la Computación de la Universidad de Utrecht, Países Bajos, así como una Maestría en Ciencias de la Computación de la Universidad del Sarre, en Saarbrücken, Alemania. Sus áreas de interés son la investigación educativa, la inteligencia artificial en la educación y el pensamiento computacional. ORCID: https://orcid.org/0000-0002-6931-9787 .

3 https://www.socrative.com/